Forschungsdatenmanagement: Gute Wissenschaftliche Praxis angewendet auf Daten

Ein zentraler Bestandteil der Guten Wissenschaftlichen Praxis (GWP) ist ein gutes Forschungsdatenmanagement (FDM).

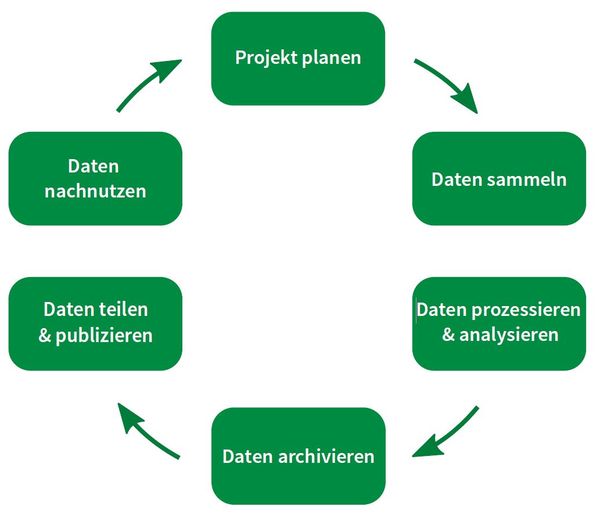

Dies bezieht sich auf jeden Schritt im Lebenszyklus von Forschungsdaten (Bild unten); von der Erstellung über die Analyse bis hin zur Veröffentlichung und Bewahrung der Daten.

Das Befolgen von stellt sicher, dass die Grundlagen und Ergebnisse wissenschaftlicher Arbeit von hoher Qualität und nachhaltigem Nutzen sind.

Gutes Forschungsdatenmanagement ist nützlich für jede Wissenschaftlerin und jeden Wissenschaftler, sowie jede Person, die in der Forschung arbeitet.

Etwa 60% der Arbeitszeit von Doktoranden wird mit der Datenaufbereitung zugebracht, um z.B. Dateien zu finden und IDs und Formate zu harmonisieren. Dies kann durch Best-Practice-FDM reduziert werden.

Gutes FDM hilft, die eigenen Daten schneller zu finden und reduziert sowohl Stress als auch das Risiko von Datenverlusten. Es hilft auch denjenigen, mit denen wir jetzt oder in der Zukunft zusammenarbeiten (auch uns selbst), den Inhalt, die Historie, die Interpretation und die Grenzen eines bestimmten Datensatzes zu verstehen.

(Meta-)Daten auffindbar zu machen, hilft auch, Forschungsergebnisse, die nicht in hochrangigen Journal-Artikeln publiziert werden konnten, zu belohnen. Die Sichtbarkeit, Zitierbarkeit und Reputation des/der Forschenden wird hierdurch verbessert.

Siehe auch Vorteile der Einhaltung der .

Forschungsdatenmanagement (FDM)

Forschungsdaten sind eine wertvolle Ressource. Um sie optimal zu nutzen, muss während des gesamten Lebenszyklusses der Forschungsdaten auf eine hohe Qualität und Nutzbarkeit geachtet werden.

Der umfasst die folgenden Phasen (siehe Abbildung) und impliziert die folgenden Überlegungen:

1. Projektplanung

- Welche Daten werden benötigt?

- Quelle, Stichprobengröße, Replikate, Typen, Bedingungen, Zeitrahmen, physischer Speicherort für Stichproben und Informationen, etc.

- Gibt es bereits existierende Daten?

- Quellen, Besitzer, Format, Referenzen, Harmonisierung

- Welche Metadaten beschreiben die Daten?

- sammle in allen Phasen des Lebenszyklus der Daten so viele Informationen wie möglich

- Wie werden die Daten organisierst und welche Ressourcen oder Informationen dafür benötigt?

- Namenskonventionen, Einheiten, Speicherung, Tools, etc.

- Wie wird sich um die Daten gekümmert?

- Datenmanagementplan, Formatierung, Eigentum, Zugangskontrolle

- Definiere Schemata und Verantwortlichkeiten!

- Namen, Metadaten, etc.

- Plane die benötigte Rechenkapazität!

- insbesondere benötigter Arbeitsspeicher (RAM)

2. Datenerhebung, -verarbeitung und -analyse

- Dokumentiere im ELN und erfasse Methoden und Codes.

- inklusive Versionen, Einstellungen, Parameter

- Erstelle Ordner für Tools und Daten.

- Stelle sicher, dass Speicherung und Backups geregelt sind.

- Kapazität, gibt es lokale Arbeitsabläufe oder nicht, Speicherzeitraum, Backup-Zeitplan und -verteilung

- Kriterien für Löschung

- Kriterien für Archivierung (wann wird archiviert, online oder nicht)

- Sammle und speichere Metadaten.

- Kontrolliere Dateiversionen.

- Gewährleiste Methodenverwaltung.

- Software-Wartung, Workflow-Entwicklung

- Implementiere Zugangskontrolle und Sicherheit.

- Aktualisiere den Datenmanagementplan.

- Schreibe README(s).

- Dokumentation von Schemata und Datenstruktur, Variablen, (Fremd-)Datenquellen, Methoden, Links (Dateien, ELN)

- Gewährleiste Reproduzierbarkeit (insbesondere mit vollständiger Dokumentation) und Interoperabilität.

- überprüfe Dateiformate: proprietäre Software wird Formate verändern und Dateien nach Updates unlesbar hinterlassen

- wähle offene, freie, persistente Formate wie pdf, csv, txt, rdf

- beachte Unterschiede zwischen Betriebssystemen, besonders wenn mit eigenem Code gearbeitet wird

- falls nötig, speichere Software und Codes gemeinsam mit den Daten ab (siehe auch )

- Stelle sicher, dass die Dateninterpretation der folgt.

3. Archivierung, Teilen, Publizieren und Nachnutzung

- Welche Daten sollen wo geteilt / publiziert / archiviert werden?

- Embargo

- Zugangslevel (offen / eingeschränkt / geschlossen)

- Repository

- DOI

- Wer bezahlt was?

- Werden auch Negativergebnisse publiziert (als Datensatz / mit Erzählung)

FAIR steht für findable, accessible, interoperable, and re-usable (auffindbare, zugängliche, interoperable und nachnutzbare) Daten [1].

Diese Prinzipien sind die gemeinsame Basis für die Nutzung von Daten und Diensten anderer sowie dafür, eigene Daten zugänglich zu machen und eine interdisziplinäre und internationale, Daten-getriebene Forschung zu ermöglichen.

Aber auch selbst profitiert man davon: nach einer Unterbrechung ist es einfacher, eigene Daten zu verstehen und sie erhalten eine bessere Qualität.

Die folgenden Absätze beschreiben Details der vier Prinzipien [2] und die Vorteile:

Findable (Auffindbar)

Voraussetzung

- Unabhängig durch Maschinen und Menschen.

- (Meta-)Daten enthalten eine global einzigartige und permanente ID (PID) für langfristige Zitierbarkeit.

- Daten werden durch umfassende Metadaten beschrieben, inklusive Herkunft.

- Metadaten enthalten klar und explizit die PID der beschriebenen Daten.

- (Meta-)Daten sind in einer durchsuchbaren Ressource registriert oder indiziert.

Accessible (Zugänglich)

Voraussetzung

- Unter klar definierten Bedingungen.

- (Meta-)Daten können mittels der PID und einem standardisierten Kommunikationsprotokoll abgerufen werden.

- Das Protokoll ist offen, frei und universell implementierbar.

- Das Protokoll erlaubt, Methoden der Authentifizierung und Autorisierung zu implementieren.

- Metadaten können eingesehen werden, selbst wenn die Daten nicht (mehr) zugänglich sind.

Interoperable (Interoperabel)

Voraussetzung

- Unabhängig durch Maschinen und Menschen.

- (Meta-)Daten nutzen eine formale, zugängliche, gebräuchliche und öffentlich zugängliche Sprache zur Wissenspräsentation.

- Dies erlaubt die Kombination mit anderen Datensätzen .

- (Meta-)Daten nutzen Vokabularien, die den FAIR-Prinzipien folgen.

- Metadaten enthalten qualifizierte Referenzen zu anderen (Meta-)Datensätzen.

- Dateiformate sind nicht-proprietär, d.h., offen, frei und standardisiert.

Re-usable (Nachnutzbar)

Ziel

- Unter klar definierten Bedingungen und korrekt zitiert.

- (Meta-)Daten sind mit einer Vielzahl an exakten und relevanten Attributen umfassend beschrieben.

(Meta-)Daten sind mit einer definierten und zugänglichen Datennutzungslizenz publiziert.

(Meta-)Daten enthalten detaillierte Informationen zu ihrer Entstehung und Herkunft.

(Meta-)Daten entsprechen Domänen-relevanten Community-Standards

Vorteile von FAIRness

Datenqualität wird verbessert und hilft, Reputation aufzubauen.

Zeiteffizienz: eigene (und fremde) Daten können schneller gefunden und verstanden werden, die Weitergabe wird vereinfacht

Forschungsergebnisse werden nachvollziehbarer, wenn Datensätze gemeinsam mit ihrer Geschichte veröffentlicht werden.

Rigorose Dokumentation verbessert Transparenz und Reproduzierbarkeit.

Sichtbarkeit wird dank besserer Auffindbarkeit und besserem Zugang von und zu Datensätzen erhöht, was wiederum ein Feedback von Kollegen erleichtert.

Forschung wird effizienter: redundante Arbeit wird minimiert.

Neue Forschungsfragen ergeben sich aus vorhergehenden Entdeckungen und den dazugehörigen Datensätzen .

Kollaboration wird unterstützt, sowohl innerhalb eines Forschungsprojektes als auch weltweit.

"Open Science" ist bei der Verwendung von Steuergeldern eine Selbstverständlichkeit: Unsere Forschungsergebnisse gehören der Gesellschaft. Allerdings können oder sollen nicht alle Datensätze sofort für alle gleich zugänglich sein, zum Beispiel, wenn ein Patent erteilt werden soll.

Um beiden Bedürfnissen gerecht zu werden, kann ein Kompromiss darin bestehen, Metadaten offen zur Verfügung zu stellen, den dazugehörigen Datensatz jedoch unter beschränkten Zugang zu stellen (Zugang auf Anfrage / "access upon request") oder nur die Metadaten zu veröffentlichen (geschlossene Daten / "closed data").

Die FAIR-Prinzipien leiten hier das bestmögliche Forschungsdatenmanagement im Einklang mit GWP, während "Open Science" ein Ziel ist, das leicht erreicht werden kann, wenn FAIR-Prinzipien befolgt werden.

[1] Wilkinson, M. D., et al. The FAIR Guiding Principles for scientific data management and stewardship. Sci. Data 3:160018 doi: (2016).

[2] GO FAIR: Fair principles [] (last accessed 2021-01-27)

An jeder Stelle des sind die leitenden hilfreich, verlässliche und reproduzierbare Daten und Metadaten (Information & Wissen) als Basis für zukünftige Forschung und Zusammenarbeit zu produzieren.

FDM beginnt mit dem Anlegen und Benennen eines Ordner, dem Benennen von Dateien und der Aufzeichnung der Historie (z.B. mit einem Link zum entsprechenden ELN-Eintrag).

Bei der Pflege von Daten und Ergebnissen beinhaltet FDM auch, Voraussetzungen und Verantwortungen zu bedenken und festzulegen.

Die Gewährleistung einer sicheren Aufbewahrungs- und Backup-Strategie (die mit der IT-Abteilung zu besprechen / zu kommunizieren ist) zusammen mit klaren Möglichkeiten, Daten zu finden und darauf zuzugreifen, ist Teil von Best-Practice.

Sich gut um die eigenen Daten zu kümmern, ist "Data Stewardship" (der Prozess und die Einstellung, auf der gutes Forschungsdatenmanagement basiert) - daher liegt die Verantwortung bei jedem selbst.

Um dabei zu unterstützen, beschäftigt das FLI einen , an den man sich mit Fragen wenden kann und der Schulungen und Beratung zu allen Themen rund um FDM anbietet.

- forschungsdaten.info [, ]

- Kontaktstelle Forschungsdatenmanagement der Friedrich-Schiller-Universität (KSFDM FSU) [, ]

- Thüringer Kompetenznetzwerk Forschungsdatenmanagement (TKFDM) [, ]

- MANTRA — Research Data Management Training []

- H2020 Programme — Guidelines on FAIR Data Management in Horizon 2020 (2016) []

- DFG — Leitlinien zum Umgang mit Forschungsdaten (2015) []

- Leibniz-Leitlinie zum Umgang mit Forschungsdaten (2018) []